Kryzysowi replikacji w psychologii kończą się wymówki

Kolejny duży projekt wykazał, że tylko połowa badań może być powtórzona. I tym razem zwykłe wyjaśnienia upadły.

19 listopad 2018

Przez ostatnie kilka lat międzynarodowy zespół prawie 200 psychologów próbował powtórzyć zestaw wcześniej opublikowanych eksperymentów ze swojej dziedziny, aby sprawdzić, czy może uzyskać takie same wyniki. Mimo najlepszych starań projekt, nazwany Many Labs 2, powiódł się tylko w 14 z 28 przypadków. Sześć lat temu mogło to być szokujące. Teraz przychodzi jako oczekiwana (choć wciąż nieco niepokojąca) wiadomość.

W ostatnich latach stało się boleśnie jasne, że psychologia stoi w obliczu „kryzysu replikowalności„, w którym nawet słynne, od dawna znane zjawiska – rzeczy z podręczników i TED Talks – mogą nie być prawdziwe. Mamy do czynienia z gruntowaniem społecznym [social priming], gdzie podprogowe ekspozycje mogą wpływać na nasze zachowanie oraz wyczerpaniem ego, pomysł, że mamy ograniczony zapas siły woli, który może zostać wyczerpany. A także hipoteza facial-feedback, która po prostu mówi, że uśmiechanie się sprawia, że czujemy się szczęśliwsi.

Jeden po drugim, badacze próbowali powtórzyć klasyczne eksperymenty stojące za tymi znanymi efektami – i nie udało się. A kiedy psychologowie podejmują się dużych projektów, takich jak Many Labs 2, w których masowo replikują poprzednie eksperymenty, udaje im się to średnio w połowie przypadków.

Fakty o Psychiatrii [DSM] i Wielkiej Farmacji — dr James Davies

Jak na ironię, wydaje się, że jednym z najbardziej wiarygodnych odkryć w psychologii jest to, że tylko połowa badań psychologicznych może być z powodzeniem powtórzona.

Ten wskaźnik niepowodzeń jest szczególnie bolesny, mówi Simine Vazire z Uniwersytetu Kalifornijskiego w Davis, ponieważ zespoły działające w ramach Many Labs 2 próbowały replikować badania, które zrobiły furorę i były bardzo cytowane. Psychologowie „powinni przyznać, że nie uzyskaliśmy wyników, które byłyby tak solidne, jak się spodziewaliśmy lub jak reklamowaliśmy je w mediach lub wśród decydentów” – mówi. „To może grozić podważeniem naszej wiarygodności na krótką metę, ale zaprzeczanie temu problemowi w obliczu tak silnych dowodów spowoduje więcej szkód na dłuższą metę”.

Wielu psychologów obwiniało niechlujne praktyki za te niepowodzenia w replikacji. Ich koledzy, jak twierdzą, są zbyt chętni do prowadzenia małych i statystycznie słabych badań, w których uzyskują mylące wyniki będące ślepym trafem, wydurniają się z danymi, dopóki nie dostaną czegoś interesującego, lub do publikowania tylko pozytywnych wyników, podczas gdy negatywne ukrywają w swoich szufladach.

Ale sceptycy argumentowali, że mylnie nazwany „kryzys” ma bardziej prozaiczne wyjaśnienia. Po pierwsze, same próby replikacji mogą być zbyt małe. Po drugie, zaangażowani w nie badacze mogą być niekompetentni lub brakować im wiedzy, by prawidłowo przeprowadzić oryginalne eksperymenty. Po trzecie, ludzie się różnią i dwie grupy naukowców mogą skończyć z bardzo różnymi wynikami, jeśli przeprowadzą ten sam eksperyment na dwóch różnych grupach ochotników.

Projekt Many Labs 2 został specjalnie zaprojektowany, aby odpowiedzieć na te krytyczne uwagi. Przy 15305 uczestnikach, nowe eksperymenty miały średnio 60 razy więcej ochotników niż badania, które próbowano replikować. Naukowcy zaangażowani w badania współpracowali z naukowcami stojącymi za oryginalnymi badaniami, aby przedtem zweryfikować i sprawdzić każdy szczegół eksperymentów. Powtarzali te eksperymenty wiele razy, z ochotnikami z 36 różnych krajów, aby sprawdzić, czy badania będą się powtarzać w niektórych kulturach i kontekstach, ale nie w innych. „To był największy niedźwiedź w tym projekcie” – mówi Brian Nosek z Centrum Otwartej Nauki, który pomagał w jego koordynacji. „To 28 artykułów w jednym”.

Pomimo dużych rozmiarów próbek i błogosławieństwa oryginalnych zespołów, zespołowi nie udało się zreplikować połowy badań, na których się skupił. Nie udało się na przykład wykazać, że ludzie podświadomie wystawieni na działanie koncepcji ciepła byli bardziej skłonni wierzyć w globalne ocieplenie, albo że moralne wykroczenia [fikołki] wywołują potrzebę fizycznej czystości w stylu Lady Makbet, albo że ludzie, którzy dorastają z większą liczbą rodzeństwa, są bardziej altruistyczni. I tak jak w poprzednich dużych projektach, obstawiający online byli zaskakująco dobrzy w przewidywaniu z wyprzedzeniem, które badania ostatecznie się zreplikują. W jakiś sposób potrafili wyczuć, które badania są wiarygodne.

Ale inne intuicje były mniej dokładne. W 12 przypadkach naukowcy stojący za oryginalnymi badaniami sugerowali cechy, które replikanci powinni uwzględnić. Mogli, na przykład, znaleźć te same wyniki tylko u kobiet, a nie u mężczyzn, lub u ludzi z pewnymi cechami osobowości. W prawie każdym przypadku te sugerowane cechy okazywały się nieistotne. Wyniki po prostu nie były aż tak zmienne.

Podobnie, Many Labs 2 „zostało wyraźnie zaprojektowane, aby zbadać, jak bardzo efekty różniły się w zależności od miejsca i kultury„, mówi Katie Corker z Grand Valley State University, która przewodniczy Society for the Improvement of Psychological Science. „I oto zaskakujący wynik: Wyniki wcale nie wykazują dużej zmienności„. Jeśli jeden z uczestniczących zespołów z powodzeniem zreplikował badanie, inni też to zrobili. Jeśli badanie nie udało się zreplikować, miało tendencję do porażki wszędzie.

Warto się nad tym zatrzymać, ponieważ jest to poważny cios dla jednej z najczęściej przytaczanych krytyk retoryki „kryzysu odtwarzalności”. Z pewnością, argumentują sceptycy, mrzonką jest oczekiwanie, że badania będą wszędzie replikowane. „Istnieje ogromne przywiązanie do próbki” – mówi Nosek. „Twoja próba replikacji nie powiodła się? To musi być dlatego, że ty robiłeś to w Ohio, a ja w Wirginii, a ludzie są różni. Ale te wyniki sugerują, że nie możemy tak łatwo odrzucić tych niepowodzeń.”

Nie oznacza to, że różnice kulturowe w zachowaniu są nieistotne. Jak zauważa Yuri Miyamoto z University of Wisconsin w Madison w towarzyszącym komentarzu, „W dobie globalizacji psychologia pozostała w dużej mierze europejska i amerykańska.” Wielu badaczy zauważyło, że ochotnicy z zachodnich, wykształconych, uprzemysłowionych, bogatych i demokratycznych krajów [Western, Educated, Industrialized, Rich, and Democratic –WEIRD] są niezwykłym wycinkiem ludzkości, który myśli inaczej niż ci z innych części świata.

W większości eksperymentów w ramach Many Labs 2 zespół stwierdził bardzo niewiele różnic między wolontariuszami w krajach WEIRD a tymi z innych krajów. Miyamoto zauważa jednak, że analiza była nieco surowa – biorąc pod uwagę „kraje nie należące do grupy WEIRD”, wrzucono do niej ludzi z tak różnych kultur jak Meksyk, Japonia czy RPA. „Badania międzykulturowe,” pisze, „muszą być oparte na dokładnych analizach każdego z zaangażowanych kontekstów kulturowych.”

Brian Nosek się z tym zgadza. Chciałby zobaczyć duże projekty replikacyjne, które obejmują więcej ochotników z innych społeczeństw niż zachodnie, lub które próbują sprawdzić zjawiska, których można się spodziewać, że będą się znacznie różnić poza bańką krajów WEIRD. „Czy musimy zakładać, że bycie z tych krajów ma znaczenie tak bardzo, jak nam się wydaje?” pyta. „Nie mamy na to dobrej bazy dowodowej”.

Źródło: Psychology’s Replication Crisis Is Running Out of Excuses

Zobacz na: Płeć a środowisko akademickie

Czy już nadszedł czas żeby zakładać, że badania nad zdrowiem są fałszywe, dopóki nie zostanie udowodnione, że jest inaczej?

Obserwacja wielu badaczy korzystających z tych samych danych i hipotez ujawnia ukryty wszechświat niepewności

73 zespoły testowały te same hipotezy z tymi samymi danymi. Niektóre znalazły negatywne wyniki, niektóre pozytywne, a kolejne guzik znalazły. Brak efektu ekspertyzy albo błędu potwierdzenia. „Idiosynkratyczna zmienność badaczy stanowi zagrożenie dla wiarygodności ustaleń naukowych”.

„W niniejszym opracowaniu badamy, jak wybory analityczne badaczy wpływają na wiarygodność ustaleń naukowych. Większość dyskusji na temat problemów z wiarygodnością w nauce skupia się na systematycznych uprzedzeniach. My poszerzamy tę perspektywę, aby podkreślić idiosynkrazję świadomych i nieświadomych decyzji, które badacze podejmują podczas analizy danych. Koordynowaliśmy 161 badaczy w 73 zespołach badawczych i obserwowaliśmy ich decyzje badawcze, gdy używali tych samych danych do niezależnego testowania tej samej prominentnej hipotezy z zakresu nauk społecznych: że większa imigracja zmniejsza poparcie dla polityki społecznej wśród społeczeństwa. W tym typowym przypadku badań z zakresu nauk społecznych, zespoły badawcze przedstawiły zarówno szeroko rozbieżne wyniki liczbowe, jak i merytoryczne wnioski, pomimo identycznych warunków początkowych. Ekspertyza badaczy, ich wcześniejsze przekonania i oczekiwania ledwie przewidują duże zróżnicowanie wyników badań. Ponad 95% całkowitej wariancji w wynikach liczbowych pozostaje niewyjaśnione nawet po jakościowym kodowaniu wszystkich możliwych do zidentyfikowania decyzji w procesie pracy każdego zespołu. Ujawnia to wszechświat niepewności, który pozostaje ukryty, gdy rozważa się pojedyncze badanie w izolacji. Idiosynkratyczna natura tego, jak zmieniały się wyniki i wnioski badaczy, jest wcześniej niedocenianym wyjaśnieniem, dlaczego wiele hipotez naukowych pozostaje kwestionowanych. Wyniki te wzywają do większej epistemicznej pokory i jasności w raportowaniu wyników badań naukowych.” – Źródło: PNAS, Vol. 119 | No. 44; 28 październik 2022

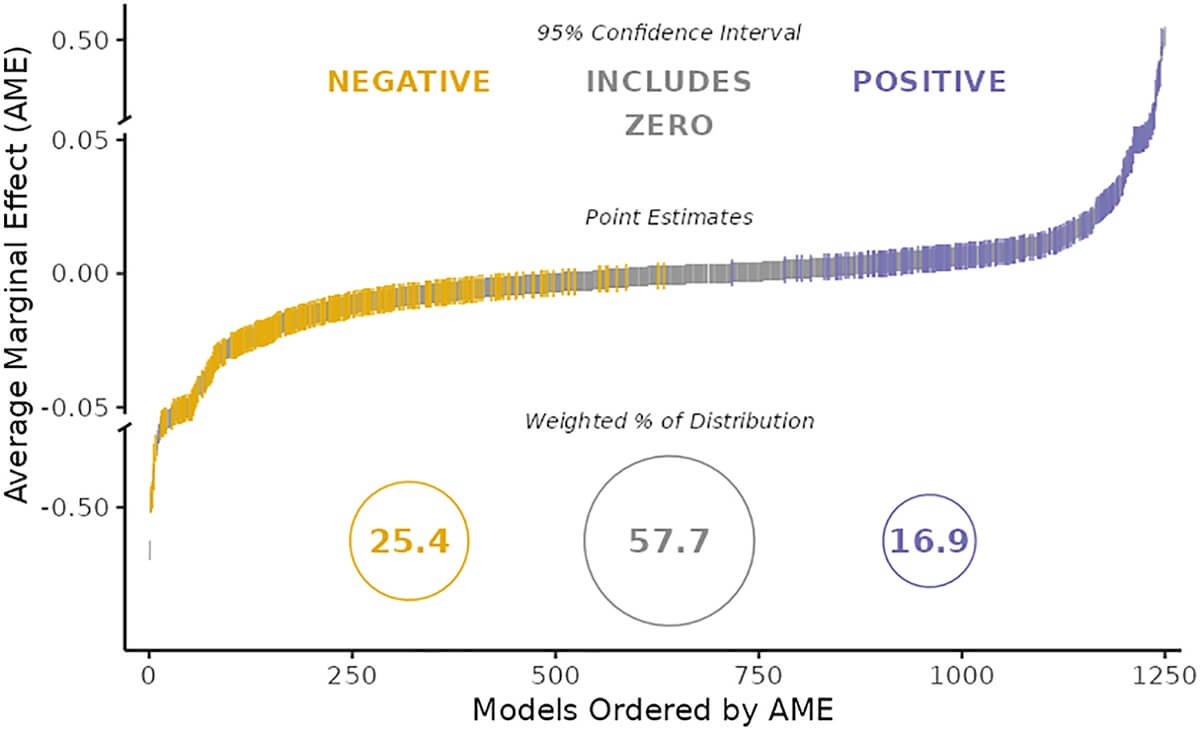

Duże zróżnicowanie wyników z 73 zespołów testujących tę samą hipotezę z tymi samymi danymi. Rozkład szacowanych średnich efektów krańcowych [Average Marginal Effect – AME] we wszystkich zbieżnych modelach (n = 1253) obejmuje wyniki, które są negatywne (żółte; w kierunku przewidywanym przez daną hipotezę, którą zespoły testowały), nieróżniące się od zera (szare) lub pozytywne (niebieskie) z 95% Przedziałem Ufności. Średnie efekty krańcowe są standaryzowane względem osi xy. Oś y zawiera dwie przerwy w skalowaniu na poziomie ±0,05. Liczby wewnątrz kółek reprezentują procenty rozkładu każdego wyniku odwrotnie ważone przez liczbę modeli na zespół.

Źródło: Observing many researchers using the same data and hypothesis reveals a hidden universe of uncertainty

Te same dane, różne wnioski

Te same dane, różne wnioski: Radykalne rozproszenie wyników empirycznych, gdy niezależni analitycy operacjonalizują i testują tę samą hipotezę

– Nowa platforma (DataExplained) pomaga analitykom uzasadniać preferowane i odrzucane ścieżki analityczne w czasie rzeczywistym.

– Niezależni analitycy wykorzystali DataExplained do przetestowania dwóch hipotez na tym samym zbiorze danych w ramach inicjatywy crowdsourcowej [pozyskiwanie czegoś w społeczności].

– Analitycy przeprowadzili radykalnie różne analizy i zgłosili rozproszone wielkości efektów, w tym znaczące efekty w przeciwnym kierunku dla tej samej hipotezy.

– Analiza wielowymiarowa BOBA podkreśla znaczenie operacjonalizacji zmiennych poza wyborami statystycznymi.

„W tej inicjatywie crowdsourcowej niezależni analitycy wykorzystali ten sam zbiór danych do przetestowania dwóch hipotez dotyczących wpływu płci i statusu zawodowego naukowców na gadatliwość podczas spotkań grupowych. Nie tylko podejście analityczne, ale także operacjonalizacja kluczowych zmiennych pozostały bez ograniczeń i zależały od indywidualnych analityków. Na przykład, analitycy mogli zdecydować się na operacjonalizację statusu jako stanowiska, rankingu instytucjonalnego, liczby cytowań lub jakiejś kombinacji. Aby zmaksymalizować przejrzystość procesu, w którym dokonywane są wybory analityczne, analitycy korzystali z opracowanej przez nas platformy o nazwie DataExplained, aby uzasadnić preferowane i odrzucone ścieżki analityczne w czasie rzeczywistym. Analizy pozbawione wystarczającej ilości szczegółów, powtarzalnego kodu lub zawierające błędy statystyczne zostały wykluczone, co dało 29 analiz w ostatecznej próbie. Badacze przedstawili skrajnie różne analizy i rozproszone wyniki empiryczne, w wielu przypadkach uzyskując znaczące efekty w przeciwnych kierunkach dla tego samego pytania badawczego. Analiza multiverse Boba pokazuje, że decyzje dotyczące sposobu operacjonalizacji zmiennych wyjaśniają zmienność wyników ponad i poza wyborami statystycznymi (np. zmienne towarzyszące). Subiektywne decyzje badaczy odgrywają kluczową rolę w tworzeniu raportowanych wyników empirycznych, podkreślając potrzebę otwartych danych, systematycznego sprawdzania solidności i przejrzystości w odniesieniu do podjętych i niepodjętych ścieżek analitycznych. Omówiono implikacje dla organizacji i liderów, których decyzje opierają się częściowo na odkryciach naukowych, raportach konsultingowych i wewnętrznych analizach naukowców zajmujących się danymi.” – Źródło: Organizational Behavior and Human Decision Processes, Volume 165, July 2021, Pages 228-249; Same data, different conclusions: Radical dispersion in empirical results when independent analysts operationalize and test the same hypothesis https://www.sciencedirect.com/science/article/pii/S0749597821000200

Najnowsze komentarze